엔비디아 GPU 손잡은 SK하이닉스 HBM3

AMD와 반전 노리는 삼성전자 HBM-PIM

|

25일 업계에 따르면 SK하이닉스는 지난해 하반기 인위적 감산을 공식화했지만 고대역폭·고용량 메모리 제품 'HBM3' 생산은 줄이지 않았다.

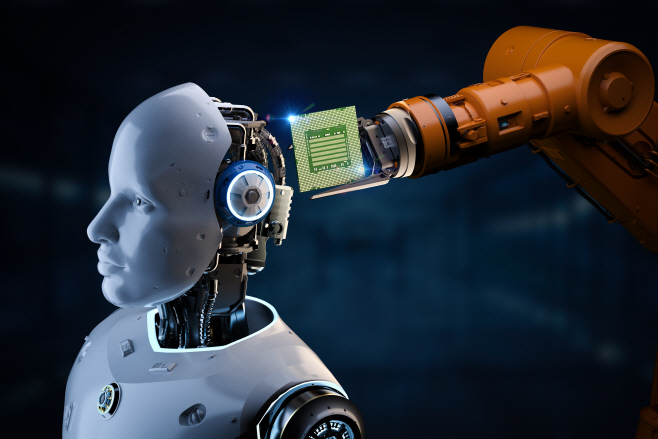

메모리반도체 주요 고객인 빅테크 기업들이 AI 연구, 데이터 센터 투자를 속속 발표하고 있어서다. 챗GPT와 같은 서비스를 운영하려면 AI에 신경망 학습을 시킬 수 있는 그래픽처리장치(GPU)가 필요한데, 여기에 고용량·고대역폭 D램이 대거 탑재된다. SK하이닉스가 생산하는 HBM3도 엔비디아의 데이터센터용 GPU에 대부분 탑재되는 것으로 알려졌다.

삼성전자도 AI시대를 주도할 차세대 메모리반도체 개발에 한창이다. 삼성전자의 차세대 메모리솔루션을 대표하는 기술은 'PIM'(Processing in memory)이다. PIM은 데이터 연산의 일부 기능을 메모리 내부에 구현한 것이다. 데이터가 메모리와 로직 칩을 오가는 횟수가 줄어드는 만큼 전력 소모량이 적고 연산 속도가 빠르다. 삼성전자는 AMD와 협력해 'HBM-PIM'을 개발하기도 했다. HBM-PIM을 활용하면 기존 GPU 가속기 대비 평균 성능이 2배 증가하고 에너지 소모는 50% 감소한다.

실제로 오픈AI의 챗GPT 공개 이후 마이크로소프트, 메타, 아마존웹서비스 등 빅테크 기업들의 투자 발표가 줄을 잇고 있다. 아마존웹서비스는 지난 21일 미국 버지니아 데이터센터에 오는 2040년까지 350억 달러(약 40조원) 규모의 투자를 추진한다고 밝혔다. 메타는 지난 연말까지 데이터센터 투자 규모를 줄일 수 있다는 전망이 우세했지만, 최근엔 최소 9%에서 최대 21%규모의 설비투자 증액을 예상한다고 밝혔다. 마이크로소프트는 지난 23일 챗GPT를 공개한 오픈AI와 파트너십을 체결했다. 블룸버그에 따르면 마이크로소프트는 향후 수년간 100억 달러(약 12조3000억원)를 오픈AI에 투자할 것으로 알려졌다.

김영건 미래에셋 연구원은 "챗GPT 대중화는 곧 GPU 수요를, 간접적으로 D램 수요를 촉진시키는 요인이 될 것"이라며 "데이터센터용 GPU에 HBM D램이 탑재되며 기존 제품보다 두 배 이상 가격대가 형성돼있다"고 설명했다.

한편 오픈AI는 지난해 12월 1일 대화형 AI 모델 챗GPT를 공개했다. 사용자가 질문을 남기면 챗GPT가 인터넷 상에 게재돼있는 수많은 텍스트를 검토해 관련 답변을 준다. 자료 조사나 보고서 작성, 온라인 필기시험을 순식간에 해결해주는 AI가 등장한 셈이다. 챗GPT 공개 5일만에 글로벌 사용자 수는 100만명을 돌파했다. 시장조사업체 IDC에 따르면 초거대 AI를 포함한 전 세계 AI 시장 규모는 오는 2024년 5543억 달러(약 685조원)에 이를 전망이다.